Bislang standen Wissenschaftlern für Verhaltensexperimente nur eingeschränkte und aufwendige Methoden zur Verfügung, um Verhalten zu erkennen und zu steuern. „Mithilfe der in den vergangenen Jahren entwickelten KI-unterstützten Körperhaltungserkennung von Tieren lässt sich neuerdings die zeitliche und räumliche Abfolge von Bewegungen genauer bestimmen“, erklärt Studienleiter Dr. Martin Schwarz vom Institute of Experimental Epileptology and Cognition Research (EECR) des Universitätsklinikums Bonn. Er ist Mitglied des Transdisziplinären Forschungsbereichs (TRA) „Leben und Gesundheit“ der Universität Bonn – einem von sechs fakultätsübergreifenden Forschungsverbünden, in denen Wissenschaftler aus den unterschiedlichen Disziplinen zusammenkommen, um gemeinsam an zukunftsrelevanten Forschungsthemen der Exzellenzuniversität zu arbeiten. Ein wichtiges Ziel der TRA ist es, Forschung an der Schnittstelle zwischen Biomedizin und künstlicher Intelligenz voranzutreiben.

Beobachtung von sich bewegenden Mäusen

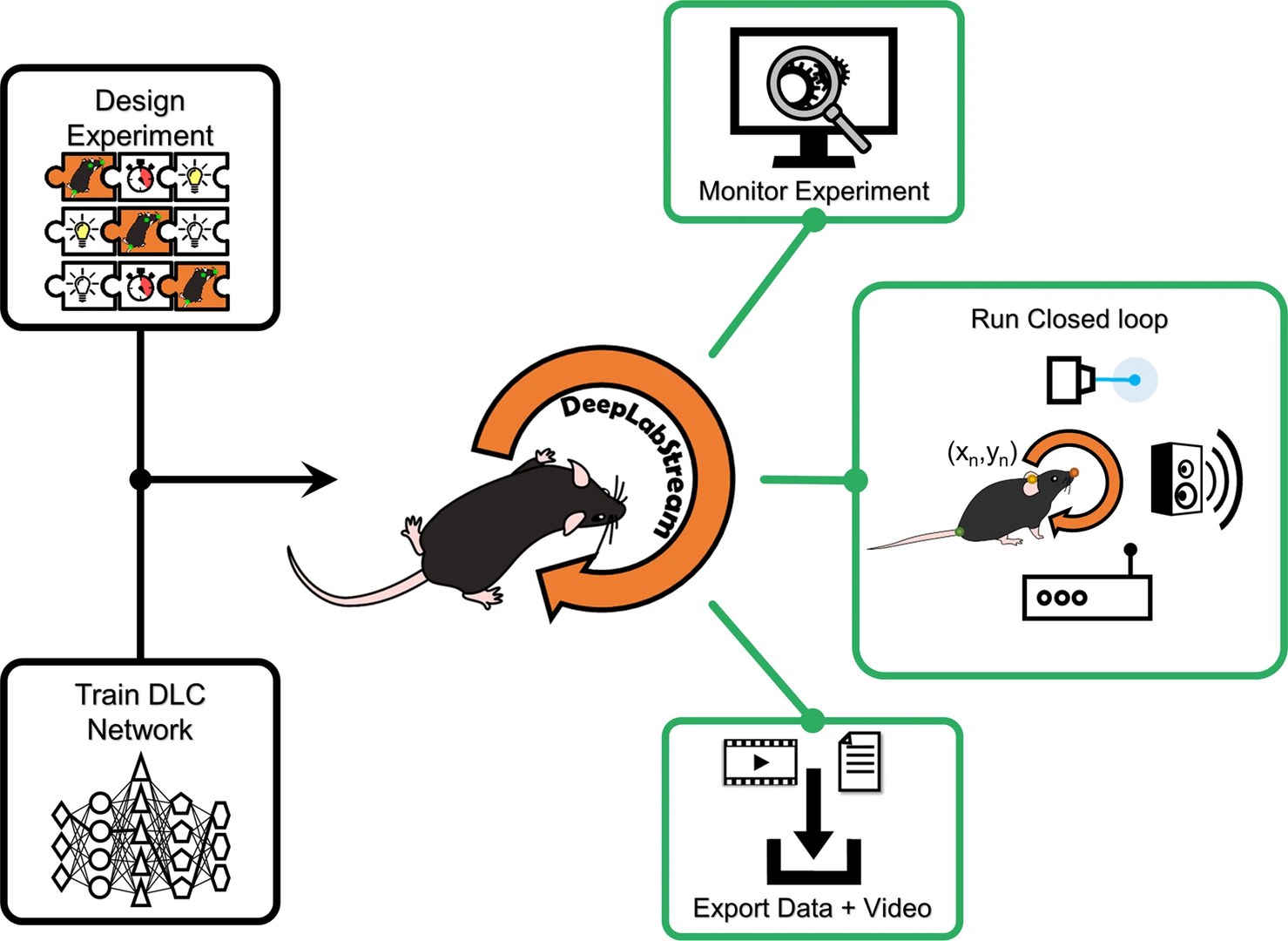

Um die DeepLabStream (DLStream) genannte Methode zu testen, beobachteten die Wissenschaftler Mäuse, die sich in einem Kasten frei bewegten. Die Mäuse wurden mittels DLStream so konditioniert, dass sie sich beim Betrachten eines bestimmten Bildes in einem festgelegten Zeitraum in eine Ecke des Kastens bewegten, um sich eine Belohnung abzuholen. Kameras erfassten die Bewegungen der Tiere, und das System erstellte automatisch Protokolle der Bewegungen.

In einem weiteren Experiment zeigten die Wissenschaftler einen besonderen Clou des neuen Systems: In Abhängigkeit der Kopfneigung schafften es die Forscher, die dafür verantwortlichen neuronalen Netze zu markieren. Hierzu nutzten sie bestimmte Proteine, die nur durch die Bestrahlung von Licht im Gehirn bei gesuchten Kopfneigungen aktiv werden und die zugrundeliegenden neuronalen Netzwerke farblich markieren. Das Proteinsystem wird Cal-Light bezeichnet. Wurden die entsprechenden, kopfneigungsabhängigen neuronalen Netzwerke nicht aktiviert, blieb eine entsprechende Markierung aus – was den kausalen Zusammenhang verdeutlichte. „Wir konnten zeigen, dass sich mithilfe der Methode zum ersten Mal aktive neuronale Schaltkreise während ausgewählter Verhaltensepisoden dauerhaft markieren und in weiterer Folge auch manipulieren lassen“, betont Jens Schweihoff, der die Studie im Rahmen seiner Doktorarbeit am Universitätsklinikum Bonn durchführte.

Verhaltenserkennung in Echtzeit

Bisher war ein limitierender Faktor in der Anwendbarkeit von Cal-Light, dass sich komplexe Verhaltensepisoden nicht exakt in Echtzeit erkennen ließen. Die neue Methode DLStream hat nun eine zeitliche Auflösung im Millisekundenbereich. „Da DLStream eine Echtzeit-Verhaltenserkennung ermöglicht, wird das verfügbare Anwendungsspektrum der Cal-Light-Methode erheblich erweitert, und es werden automatisierte, verhaltensabhängige Steuerungen während laufender Experimente möglich“, betont Jens Schweihoff. „Wir glauben, dass Wissenschaftler mithilfe dieser Kombination von Methoden nun besser die kausalen Zusammenhänge von Verhalten und den zugrunde liegenden neuronalen Netzwerken studieren können.“

Bisher wurde die Methode bei Verhaltensexperimenten von Mäusen getestet, die Forscher gehen aber davon aus, dass sie in Zukunft auch ohne Einschränkungen bei anderen Tieren angewendet werden kann.

Nach Einschätzung der Wissenschaftler kann die neue Methode erheblich die Reproduzierbarkeit und Effektivität von Experimenten steigern, da die wichtigen Verhaltensparameter, zum Beispiel die Position, Geschwindigkeit und Körperhaltung des Versuchstiers mit hoher zeitlicher Auflösung und Genauigkeit berechnet werden können. Das reduziert die Variabilität, also die Unterschiedlichkeit der beobachteten Werte, zwischen einzelnen Experimenten deutlich.

Über eine Open-Source-Plattform ist die Software mittlerweile für Wissenschaftler weltweit zugänglich, was ihnen ermöglichen soll, ein breites Spektrum an Verhaltensexperimenten mit KI-Unterstützung durchzuführen und zu automatisieren.

DeepLabStream als Open Source Anwendung: https://github.com/SchwarzNeuroconLab/DeepLabStream

Förderung:

Die Studie erhielt finanzielle Unterstützung durch die Deutsche Forschungsgemeinschaft im Rahmen des Sonderforschungsbereichs 1089 „Synaptic Micronetworks in Health and Disease“, das Schwerpunktprogramm 2041 „Computational Connectomics“ und die Volkswagen Stiftung.

Publikation: Jens F. Schweihoff, Matvey Loshakov, Irina Pavlova, Laura Kück, Laura A. Ewell & Martin K. Schwarz: DeepLabStream enables closed-loop behavioral experiments using deep learning-based markerless, real-time posture detection. Communications Biology, DOI: 10.1038/s42003-021-01654-9

https://www.nature.com/articles/s42003-021-01654-9

Kontakt:

Dr. Martin K. Schwarz

AG Funktionelle Neurokonnektomik

Institut für Experimentelle Epileptologie und Kognitionsforschung (IEECR)

Universität Bonn, Universitätsklinikum Bonn

Tel: +228-28719-266

E-Mail: Martin.Schwarz@ukbonn.de