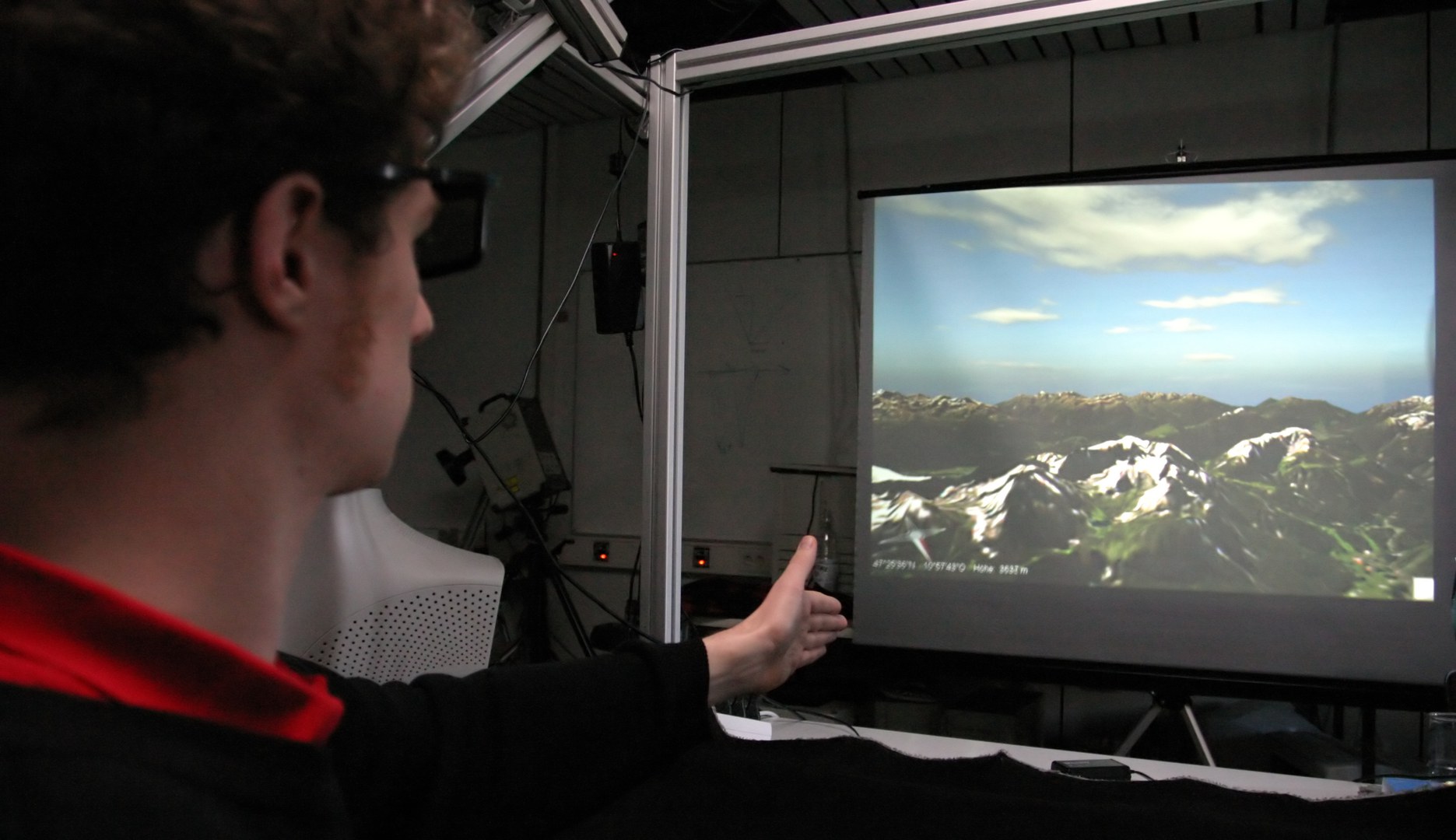

Was stört, ist der rote Kragen. Sonst könnte man Markus Schlattmann mit seinen dunklen Klamotten und der schwarzen Brille für einen der "Men in Black" halten. Vor allem, wenn er wie jetzt seine Hand zur Pistole formt.

Der Informatiker spielt aber nicht etwa "Räuber und Gendarm": Durch einfache Schlenker seiner Hand steuert er ein virtuelles Flugzeug durch die Alpen. Eine lässige Drehung aus dem Handgelenk, schon kippt der Horizont zur Seite. Nun knickt Schlattmann das Handgelenk nach unten. Brav nickt die Flugzeugnase gen Erdboden. Knapp über dem Zugspitzblatt fängt er den Flieger ab. Kurz geht es an schneebedeckten Felswänden entlang, dann zieht er die Maschine wieder steil zur Seite. Bei Zuschauern ohne stabilen Magen kann sich nach mehreren solcher Schwenks eine leichte Übelkeit bemerkbar machen. Was auch an den realistischen dreidimensionalen Bildern des Kooperationspartners RSS GmbH liegen mag. Die 3D-Brille trägt das Ihre zum naturgetreuen Eindruck bei.

"Handtracking" nennen die Mitarbeiter aus der Arbeitsgruppe Computergrafik der Uni Bonn ihr Verfahren: Drei Kameras verfolgen die Stellung der Finger, ein Rechner setzt die Bewegungen in Steuerbefehle um. "Das Ganze geht präzise, schnell und intuitiv", sagt Schlattmann. Er legt den Daumen auf den Zeigefinger; auf dem Projektionsschirm materialisieren sich ein paar zusätzliche Symbole. Der Informatiker klickt mit seinem Zeigefinger auf ein Kreuz, und das Fenster mit der Alpenlandschaft verschwindet. Die Leinwand wird schwarz: Demonstration beendet.

Grafikkarte übernimmt das Rechnen

"Das Besondere an unserem Verfahren ist, dass wir ohne externe Hilfsmittel auskommen", erklärt Schlattmanns Kollege Ferenc Kahlesz: "Um Handbewegungen in Echtzeit mit großer Genauigkeit verfolgen zu können, muss man normalerweise zumindest die Finger farblich markieren, damit sich die Software leichter orientieren kann. Oder man braucht dazu einen Datenhandschuh, der die Gelenkstellung per Funk oder Kabel an den Rechner meldet." Mit einem einzigen Handschuh ist es zudem oft nicht getan; schließlich haben die Nutzer unterschiedlich große Hände. Das Bonner Verfahren ist flexibler: Egal ob Kinderpatsche oder Maurerpranke, die Kameras erkennen genau, in welche Richtung der Benutzer gerade zeigt und wie seine Handfläche geneigt ist. "Dabei nutzen wir gar keine außergewöhnliche Technik", beteuert Schlattmann. "Die meiste Rechenarbeit erledigt die Grafikkarte." Und die sei auch kein anderes Modell, als heute bei schnellen Rechnern von Haus aus dabei sei. Ein weiterer Vorteil: Man muss das Verfahren nicht initialisieren. Sobald die Hand im Blickfeld der Kameras auftaucht, legt die Tracking-Software los. Bei anderen Methoden wird der Nutzer bei Programmstart aufgefordert, seine Hand in einer definierten Position an eine bestimmte Stelle zu legen.

Zum Spielen ist die neue Methode übrigens nicht primär gedacht " auch wenn sich damit aus Sicht der Informatiker auch Playstation oder X-Box viel intuitiver steuern ließen als bislang. "Wir entwickeln in einem EU-Projekt möglichst natürliche Interaktionsmöglichkeiten zwischen Mensch und Maschine", sagt Professor Dr. Reinhard Klein. Der Wissenschaftler leitet am Bonner Institut für Informatik II die Arbeitsgruppe "Computer Graphik". "Unsere Partner bauen dazu beispielsweise einen 3D-Bildschirm, der ohne Brillen oder ähnliche Hilfsmittel funktioniert."

Interesse an intuitiven und flexiblen Eingabegeräten kommt beispielsweise aus der Medizin. Beispiel Computertomographie: Hier fallen immense Datenmengen an, aus denen Grafikprogramme detaillierte dreidimensionale Bilder erzeugen. Mit der Software ist es zum Beispiel auch möglich, sich durch das Gehirn zu einem Tumor zu navigieren, ihn aus allen Blickwinkeln zu betrachten oder umliegendes Gewebe auszublenden, das den Blick auf den Krankheitsherd stört. "Eine herkömmliche Maus ist für derartige 3D-Anwendungen aber nur schlecht geeignet", betont Markus Schlattmann. "Mit einem guten Handtracking-Verfahren geht das viel einfacher und natürlicher!"

Kontakt:

Markus Schlattmann und Ferenc Kahlesz

Institut für Informatik II der Universität Bonn

Telefon: 0228/73-4122

E-Mail: markus@cs.uni-bonn.de / fecu@cs.uni-bonn.de

Professor Dr. Reinhard Klein

Telefon: 0228/73-4201

E-Mail: rk@cs.uni-bonn.de

Bilder zu dieser Pressemitteilung:

Zum Download einer Bilddatei in Originalauflösung bitte auf die Miniaturansicht klicken. Der Abdruck im Zusammenhang mit der Presseinformation ist kostenlos, dabei ist der angegebene Bildautor zu nennen.

Alle Fotos: Frank Luerweg / Uni Bonn

Markus Schlattmann durchfliegt die Alpen

Flugzeugsteuerung per Fingerzeig Flugzeugsteuerung per Fingerzeig

Neue Technik macht Datenhandschuh überflüssig

Forscher der Universität Bonn haben Computern beigebracht, auf Handbewegungen zu reagieren. Die Methode ist extrem schnell und robust: Sie funktioniert mit Kinderpatschen genauso wie mit Maurerpranken. Das Verfahren könnte die Steuerung von 3D-Anwendungen revolutionieren.

Bild Flugzeugsteuerung per Fingerzeig

© Universität Bonn

Alle Bilder in Originalgröße herunterladen

Der Abdruck im Zusammenhang mit der Nachricht ist kostenlos, dabei ist der angegebene Bildautor zu nennen.

Bild Flugzeugsteuerung per Fingerzeig

© Universität Bonn

Bild Flugzeugsteuerung per Fingerzeig

© Universität Bonn